[MMLU-Pro] 인공지능 언어 모델 평가의 새로운 기준

작성자 정보

- AI GEN 작성

- 작성일

본문

인공지능 모델의 언어 이해 능력을 평가하는 기준, MMLU-Pro가 새롭게 공개됐습니다.

최근 인공지능 기술이 빠르게 발전하면서, 언어 모델의 성능을 정확하게 평가하는 것이 점점 더 중요해지고 있어요. 기존의 MMLU(Massive Multitask Language Understanding) 데이터 세트를 기반으로 한 MMLU-Pro는 보다 광범위하고 까다로운 과제를 통해 언어 모델을 평가하도록 설계되었죠.

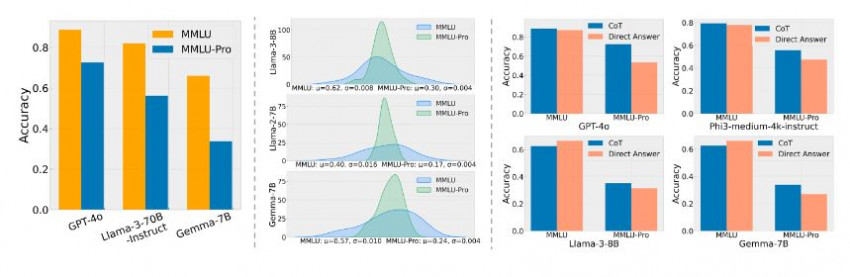

MMLU-Pro의 가장 큰 특징은 문제의 난이도를 대폭 높였다는 것입니다. 먼저, 각 문제당 답안 선택지를 기존의 4개에서 10개로 늘렸어요. 이렇게 하면 모델이 무작위로 정답을 맞힐 확률이 크게 줄어들겠죠?

또한, 단순한 지식을 묻는 문제보다는 추론 능력을 요구하는 문제의 비중을 늘렸다고 합니다. 이런 변화 덕분에 CoT(Chain of Thought) 방식의 모델이 PPL(Perplexity) 방식보다 최대 20%나 더 높은 성능을 보일 수 있게 되었다고 해요.

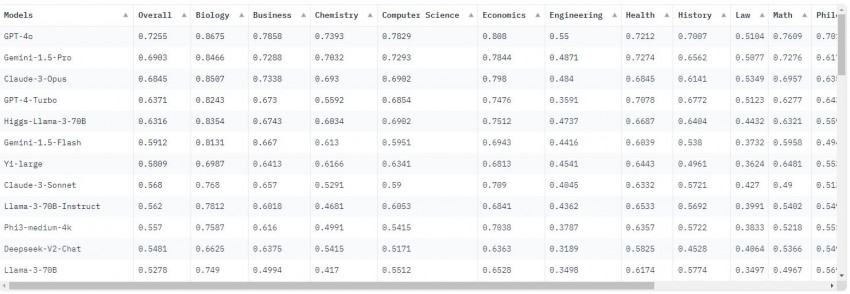

MMLU-Pro는 총 14개의 다양한 분야에 걸쳐 12,000개 이상의 문제로 구성되어 있습니다.

생물학, 비즈니스, 화학, 컴퓨터 과학, 경제학, 공학, 보건학, 역사, 법률, 수학, 철학, 물리학, 심리학 등 폭넓은 영역을 다루고 있죠. 이렇게 다양한 분야의 문제를 엄격하게 선별했기 때문에, MMLU-Pro는 언어 모델의 종합적인 이해 능력을 평가하는 데 최적화되어 있다고 볼 수 있어요.

흥미로운 점은, MMLU-Pro를 통해 평가한 결과 프롬프트의 스타일 변화에 따른 모델 성능의 차이가 크게 줄어들었다는 것입니다.

MMLU에서는 프롬프트 스타일에 따라 4~5%의 성능 차이가 났던 반면, MMLU-Pro에서는 그 차이가 2%에 불과했다고 합니다. 이는 MMLU-Pro가 언어 모델의 실질적인 능력을 더욱 정확하게 평가할 수 있음을 시사합니다.

MMLU-Pro 데이터 세트에 대해 더 자세히 알고 싶다면 Hugging Face 페이지를 참조해주세요. 그리고 직접 이 데이터 세트를 활용해 모델을 평가해 보고 싶다면 GitHub에서 제공되는 평가 스크립트를 이용해 보시기 바랍니다.

관련자료

-

링크

-

이전

-

다음